Завершена ручная проверка 532 акустических образцов хайнаньских гиббонов, включая те, что были получены во время слежения и наблюдения за гиббонами с помощью портативного диктофона, и те, что были получены с помощью автоматического диктофона. В процессе отбора изначально были выделены три категории качества записи: высокое, среднее и низкое. Было получено 44 высококачественных записи от семи индивидуальных абонентов. Семь индивидуальных абонентов - это GAM1、GBM1、GBSA、GCM1、GCM2、GDM1、GEM1, где буква после "G" означает номер семейной группы, а буква после "M/S" - индивидуальный номер взрослого самца/взрослого самца. Только около 40,9% записей были сделаны вручную. Необработанные файлы всех автоматизированных записей были предоставлены командой профессора Ван Цзичао, а соответствующие данные были сохранены в Хайнаньском институте национальных парков.

Mel-frequency cepstrum coefficients (MFCCs) - это метод извлечения признаков частотной огибающей по цепструму после ослабления высокочастотной информации на основе человеческого слуха[1], который имеет широкий спектр применения в области человеческой и биоакустики. В данном исследовании для автоматического извлечения признаков используются MFCC и разности первого и второго порядков (△、△2).

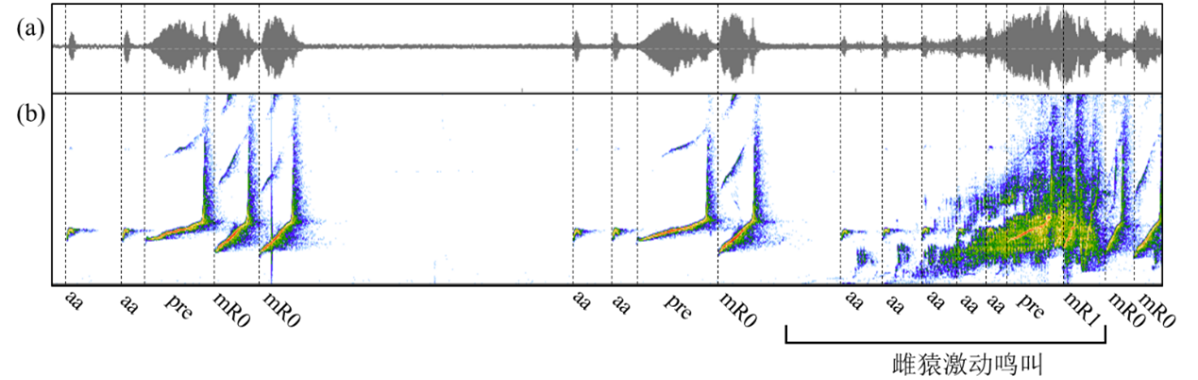

Было выявлено 5 сигнальных нот самца хайнаньского гиббона (рис. 1), включая ноту boom, ноту aa, премодулированную ноту, модулированную ноту-R0 и модулированную ноту-R1.

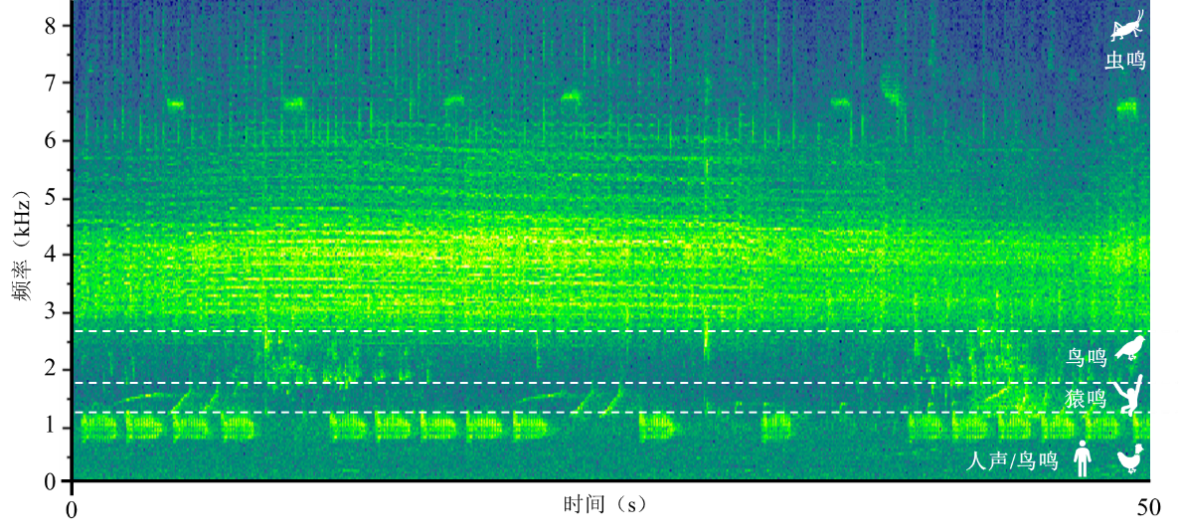

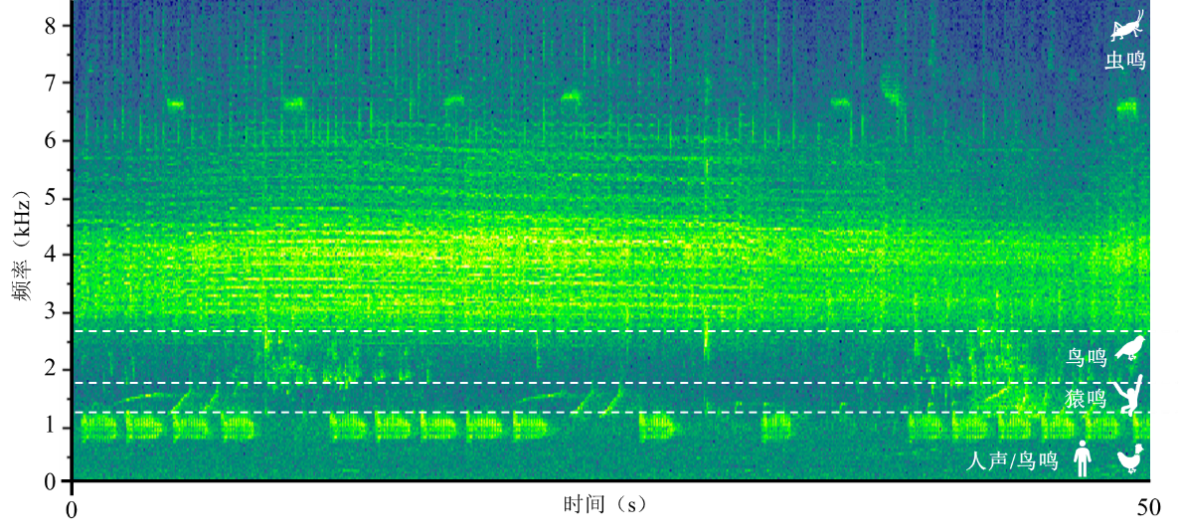

Согласно гипотезе акустической ниши, призывы разных видов различаются во временной и частотной областях (см. рис. 2), поэтому извлечение признаков в определенном частотном диапазоне может значительно уменьшить влияние шума, и чем меньше очерченный частотный диапазон, тем больше вероятность того, что будет исключено больше шума. Кроме того, когда структура каждой минимальной единицы распознавания (MRU) одинакова, сложность распознавания значительно снижается.

Учитывая вышеизложенное, на данном этапе исследования мы попробовали (1) применить только pre и (2) использовать pre + n×mR0 в качестве MRU, соответственно, и сравнить результаты классификации, чтобы определить наиболее подходящее извлечение признаков в последующей работе. В случае с аннотацией голоса все вышеперечисленные шаги могут быть реализованы автоматически с помощью кода на языке R.